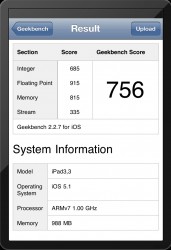

Ci sami mili Wietnamczycy co nakręcili pierwszy Unboxing iPada 3G poddali go także testowi wydajności w programie Geekbench. Program raportuje, że nowy iPad ma procesor ARMv7 taktowany 1GHz oraz 1GB RAM. Razem dało to wynik 756 punktów.

Ci sami mili Wietnamczycy co nakręcili pierwszy Unboxing iPada 3G poddali go także testowi wydajności w programie Geekbench. Program raportuje, że nowy iPad ma procesor ARMv7 taktowany 1GHz oraz 1GB RAM. Razem dało to wynik 756 punktów.

Dla porównania iPad 2 osiąga w tym teście bardzo podobne wartości czyli między 740, a 760. Mimo, że ma starszy procesor oraz mniej pamięci. Trzeba mieć jednak na uwadze, że procesor w iPadzie 3 swoją wyższość ujawni przy obliczeniach graficznych, których Geekbench nie testuje.

na moim ipadzie 2 udało mi się wyciągnąć 764 :P

cóż za moc

przecież wiadome było że to ten sam procek jedynie z podkręconą grafiką szału ni mo

No, ale przepraszam Cię, czy wydajność CPU jest nie wystarczająca w iPadzie? System jest mega zoptymalizowany, więc szczerze nie widzi mi się 'wyścig zbrojeń’ na rdzenie. GPU podrasowali, to wystarczy.

na moim iPadzie 2 wyszło 760 :)

wyjdzie A6 i będziesz pisał, że „bez tego procka ipad muli zobaczcie na a5x”

Mam nadzieję ze do iPhone’a „5” dadzą pełnoprawnego następcę A5 –>A6 :)

Ja najbardziej ciesze się z 1GB ramu. W moim pierwszym iPadzie mam 256 i bardzo to przeszkadza. Gdyby nowy iPad miał tyle samo co 2ka to przez większą rozdzielczość grafik (retina) brakowałoby pamięci tak samo jak na jedynce. Czyli z czystym smieniem bez obaw można sie przesiadać :)

Pewnie w grach będzie wolniejszy niż ipad2. Ten sam procesor i dwa razy szybsza grafika, a 4x więcej punktów. Czekamy na wyniki glbenchmark w natywnej rozdzielczości.

Niemożliwe!

Zrobią test układu w obliczeniach bez brania pod uwagę rozdzielczości i wszyscy bedą zachwyceni.

ipad 2 (GSM) 64GB bez jaila 765

wy nie kumacie – i nie rozrozniacie pojec

ten procek to CPU 2-wu rdzeniowy (jak w iPad 2) tyle ze z 4-oma rdzeniami GPU (iPad 2 mial mniej rdzeni)

o co sie mi rozchodzi – to jak jest obecnie w PC – po kiego komu procek do z 8-mioma rdzeniami jak grafe bedzie miec slaba – mocna k. graf. w PC to obecnie podstawa – CPU sie nie liczy

i tak tez Apple postapil – pewno z 90% systemu jest akcelerowane poprzez GPU a nie CPU

tak na marginesie to juz sa teorie (w branrzy PC) ze po kiego CPU jak juz GPU robi (lub MOZE robic) prawie cala robote

To fakt , przeważnie grafikę spowalnia teraz procesor :)

Wogule zapomniałem że wychodzi Ipad na dniach haha , może że w sieci jest nowa drama w postaci Mass Effect 3 :)

A czy te obliczenia graficzne wykorzystywane są przez aplikacje poza pokazywaniem grafiki?

Bo jeśli tak i cały system miałby opierać się na dodatkowych obliczeniach GPGPU (w co śmiem wątpić gdyż OpenCL stoi na bardzo niskim poziomie w OSX) wtedy iPad rozwinąłby skrzydła :)

Poczekajmy na benchmarki grafiki

takie rzeczy już masz dawno poczytaj na temat Nvidia Tesla o zniknięciu CPU można sobie jedynie pogadać rozwiązania oparte na GPU dają swoją moc w specyficznych obliczeniach, pomijając samo programowanie dla <200 rdzeni strumieniowych. A zupełnie od innej strony po co Tobie w domu taka moc obliczeniowa?

Bardziej interesuja mnie testy nowego GPU ipada z Tesla 3 ktora ma 12 rdzeni graficznych , bo nie wierze w bzdury jakie gadał Cook na konferencjii że ich GPU jest dwa razy szybszy od Tesla 3 .

Niestety ale muszę Ci powiedzieć że straszne głupoty wypisujesz. CPU zawsze będzie najważniejszy ponieważ jest ogólnego zastosowania. GPU jak na razie są to bardzo specjalizowane układy które nie są zbyt wydajne w standardowych zastosowaniach programistycznych. np. jądro każdego systemu operacyjnego do zarządzania procesami i obsługą IO używa tylko CPU, Photoshop do obróbki grafiki używa CPU, wszystkie bazy danych używają tylko CPU itp. GPU jak na razie jest używane w przypadku przekodowywania materiałów wideo, wyświetlaniu efektów graficznych (animacje, półprzezroczystości, inne bajery) w systemie operacyjnym, no i dodatkowo są też używane w wyspecjalizowanych aplikacjach liczących jak Seti@Home czy Bitcoin.

Dokładnie! Tak będą mówili wszyscy którzy dotąd twierdzili, że A5X wystarcza. Tak było z iPhonem 3GS, później z IP4 a teraz wyprzedził go wydajnością 4S.

System może sobie być zoptymalizowany ale rendering bardziej złożonej strony WWW trwa dużo dłużej niż na komputerze.

Szybszy procek by to zmienił.

Pingback: Mój MAC

A co miał powiedzieć że wolniejsze? Może porownywali z aktywnym jednym rdzeniem

chcialem tobie powiedziec ze wszystkie programy co piszesz lepiej dzialaja na CPU dlatego ze……….. SA TAK NAPISANE

prosty przyklad ktory moze pojmiesz – kiedys kiedy nie bylo akceleracji GPU w video – najmocniejszy CPU sie liczyl – powstaly programy – iiii………….. co mamy???

tak jest – teraz procek prawie nic nie musi robic – wszystko oblicza GPU – i gdyby tak kazdy program byl napisany od nowa (to jest wlasnie ten problem dlaczego nie ma takich programow duzo) ——- CPU przestalby istniec

Nie miałoby to żadnych podstaw ekonomicznych, celem firm jest zarobek nie postęp w przeciwnym razie od 6-7 lat zamiast przestarzalej technologi lcd miałbyś powszechnie dostepne matryce oled w monitorach, notebookach i telewizorach

Poczytaj najpierw na temat budowy zarówno CPU i GPU potem o programowaniu…

Możesz zacząć od tego jak chcesz wykluczyć CPU

http://www.nvidia.pl/page/gpu_computing.html

Po prostu postarają sie to zrozumieć GPU nie jest w stanie wykonać wszystkich zadań centralnego procesora i raczej sie to nie zmieni, napisze Ci że, prędzej znajdziesz w domowym komputerze procesory kwantowe

Pingback: Bardzo kompletny test iPada 3 (trzeciej generacji) | iPod.info.pl — iPod, iPad, iPhone - Blog informacyjny

Muszę was zaszokować … Moja dwójka osiągnęła dzisiaj spektakularne 1028 pkt w Geekbenchu (wczoraj upnąłem z 5.0.1 ) jest po jailu i ma zainstalowane tylko Pages i Truprint :) pzdr

jak ktoś chce screeny to dam maila